|

DÉVELOPPEMENT TECHNIQUE DE L'INTERNET |

|

Synthèse |

|

|

|

|

Le rapport a pour objet, à la fois de proposer les grandes lignes d'un état des lieux du développement technique de l'Internet dans le monde et en France, et de suggérer un premier ensemble de recommandations pour accélérer ce développement sur le territoire national. Il est écrit avec l'objectif d'alimenter un débat. Il ne prétend, en aucune manière, donner les solutions mais plutôt suggérer des voies de travail.

La mission "Développement Technique de l'Internet" fait partie du Programme d'Action Gouvernemental pour la Société de l'Information (PAGSI). Le rapport met donc l'accent sur les aspects techniques alors que d'autres rapports ont traité les aspects usages (commerce électronique, par exemple) ou réglementaires. Il doit être lu comme un élément du débat fondamental relatif au positionnement de la France dans le développement de la société de l'information.

Organisation du rapport

Le rapport comporte trois parties :

La première partie identifie les moteurs qui entraînent le développement technique de l'Internet. La variété des applications et des usages que l'Internet peut accueillir est le moteur principal comme en témoigne le rôle joué par les applications les plus connues, le courrier électronique et le World Wide Web dans la diffusion de l'Internet. L'évolution et la standardisation des technologies de l'information (matérielles et logicielles) est le second moteur puisqu'elle rend efficientes des applications par le seul progrès des caractéristiques techniques des composants (fibre optique, processeurs et mémoires, boîte à outils logiciels, ...).

La seconde partie décrit les composants techniques de l'Internet. Les cinq chapitres couvrent les réseaux de transport, la boucle locale, les interconnexions, les services d'infrastructure, les équipements.

La troisième partie met l'accent sur l'environnement économique et politique. La recherche des modèles économiques appropriés, le rôle joué par les réglementations sont évoqués dans leurs relations avec le développement technique de l'Internet.

La synthèse et les chapitres sont composés d'une présentation du contexte international, d'une appréciation de la situation en France et d'un ensemble de recommandations.

Contexte international

L'Internet est la plateforme de la convergence entre l'informatique, les télécommunications et l'audiovisuel

L'Internet est un moyen de communication (stockage et/ou transmission d'informations) au même titre que l'écriture, l'imprimerie, la radio et la télévision, le téléphone et le fax. C'est le premier moyen de communication qui ait été conçu dans l'ère numérique. C'est le premier moyen de communication qui associe télécommunications et informatique dès sa conception. Le terme de "convergence" est souvent associé à l'émergence de l'ère du numérique. Cette convergence est relative à trois composantes : les télécommunications, l'informatique et l'audiovisuel. Si l'Internet cherche à intégrer les signaux audiovisuels, ces signaux, dépendant du temps, n'ont pas été pris en compte lors de la conception de l'Internet. Toutefois, les progrès technologiques en matière de support de communications (fibre optique), de composants (processeurs, mémoires), de bibliothèques logicielles (système d'exploitation, protocoles) permettent d'affirmer désormais que la convergence aura lieu sur une infrastructure Internet.

Un moyen de communication en constante évolution

Bien que conçu il y a plus de vingt-cinq ans, l'Internet est encore en pleine évolution. Cette évolution est sans doute appelée à durer. En effet, les choix de conception de l'Internet ont repoussé l'intelligence aux extrémités du réseau (c'est à dire dans les ordinateurs qui servent d'interfaces avec les utilisateurs ou ceux qui stockent et délivrent l'information). Cette caractéristique permet à l'Internet de tirer parti "en temps réel" des progrès des matériels et logiciels informatiques. C'est cette capacité à évoluer qui permet d'envisager d'exploiter l'Internet pour des usages qui n'avaient pas été pris en compte lors de sa conception.

Un moyen de communication piloté par les applications

Evoquer le développement technique de l'Internet exige donc d'utiliser une approche dynamique où chacun doit être prêt à modifier en permanence les éléments constitutifs de son réseau. En particulier, l'équilibre entre l'offre et la demande penche du côté de la demande puisque de nouvelles applications peuvent être développées "aux extrémités" et exiger l'adaptation de l'infrastructure. Le développement du World Wide Web (ou Web) est l'exemple le plus récent et le plus spectaculaire de ce phénomène. Les applications du Web dans le domaine du commerce électronique ne faisaient pas partie des objectifs initiaux de son développement (plutôt dirigé vers le travail coopératif). Ce sont pourtant les perspectives en matière de commerce électronique qui motivent (en majorité) aujourd'hui les investissements financiers exceptionnels consentis pour développer produits et services.

Un moyen de communication qui associe développement et déploiement

Enfin, l'Internet fournit lui-même l'infrastructure pour le déploiement de nouvelles applications logicielles (eg logiciels libres ou versions prototypes des éditeurs de logiciels). Les mécanismes de diffusion de nouvelles applications ont, en effet, été mis en place depuis l'origine de l'Internet et font désormais partie de la culture du "net". Ce rapprochement entre développement et déploiement raccourcit la boucle qui lie idées, prototypes, produits et services. Depuis les protocoles de base jusqu'aux applications, le paradigme du Développement Technique de l'Internet (que les pionniers ont décrit par la devise : "rough consensus and running code") favorise l'innovation par rapport à la préservation des positions acquises.

Moteurs du Développement Technique de l'Internet

Applications et Usages

La croissance de l'Internet est provoquée par les applications. Si le courrier électronique est la plus ancienne application, sa charge sur l'infrastructure est restée modeste jusqu'à ce jour, étant donné le type (principalement du texte) des données échangées. Le Web a facilité l'accès à des images et, surtout, accéléré la navigation d'un service d'information à un autre. Les débits engendrés par l'usage du Web ont donc rapidement représenté la part la plus importante du trafic de l'Internet (aujourd'hui, un peu plus de 60%). Le déploiement futur d'applications impliquant le transfert de données audiovisuelles (téléphone, vidéoconférence, télévision) engendrera de nouveaux types de trafic et provoquera des demandes nouvelles sur l'infrastructure (bande passante mais aussi qualité de service temps-réel). Dans un autre domaine, on peut imaginer qu'une fois déployés les services d'infrastructure, le commerce électronique demandera de fournir aux utilisateurs une qualité de service largement supérieure à celle qui est disponible actuellement.

Comme toute technologie, l'Internet peut être utilisé pour le meilleur, le pire, le moyen ou le médiocre. Les applications disponibles déterminent les usages et, par conséquent, les modèles culturels associés. A titre d'illustration, le Web a été développé comme outil de travail coopératif par Tim Berners-Lee, au CERN, pour aider les physiciens des hautes énergies à collaborer à travers l'Europe. Les premières versions de logiciels permettaient à l'utilisateur de publier aussi bien que de naviguer, donnant aux fonctions de création (écriture) et d'apprentissage (lecture) le même poids. Le succès de Mosaic, le premier navigateur multiplateformes développé au NCSA (National Center for Supercomputing Applications), a rendu dissymétriques lecture et écriture, la fonction navigation étant seule supportée. Plus récemment, une évolution connue sous le nom de technologie "push" a voulu imposer un modèle de diffusion où l'utilisateur s'abonne et reçoit sans effort les informations sélectionnées par le fournisseur de service. Ce rapide historique montre comment la disponibilité d'outils logiciels peut conduire à des usages bien différents et ouvrir ou fermer des opportunités essentielles. Par exemple, on n'enseigne pas les mêmes choses aux élèves si les outils mis à leur disposition permettent de créer des services ou s'ils permettent seulement de parcourir des services créés par d'autres. En fonction du choix éducatif choisi, l'infrastructure technique nécessaire ne sera pas la même.

Technologies et Standards

Le développement de nouvelles fonctionnalités de l'Internet est assuré par des organisations construites à cet effet. Les plus connues sont l'IETF (Internet Engineering Task Force) et le W3C (World Wide Web Consortium). Ces organisations associent laboratoires de recherche, industriels, fournisseurs de services, utilisateurs, pour conduire l'évolution de l'Internet et de son application aujourd'hui majeure, le Web. Dans tous les cas, les nouvelles fonctionnalités sont mises au point "directement" sur l'Internet. Les premières versions de logiciels mettant en oeuvre les innovations sont déployées librement. Les exemples les plus célèbres sont le Web initial (issu du CERN à Genève), Mosaic, Apache, le serveur Web le plus employé encore à ce jour, malgré la présence d'offres commerciales multiples et prestigieuses. L'usage de logiciels libres préside ainsi à la mise au point puis au déploiement des nouvelles caractéristiques et nouvelles applications sur l'Internet. Etre un acteur du développement de l'Internet exige de participer aux travaux de cette communauté qui construit collectivement l'Internet de demain.

Enfin, la faisabilité de ces nouvelles applications, le réalisme de ces nouveaux usages, l'efficacité de ces nouveaux protocoles et formats sont largement dépendants de l'évolution des performances et fonctionnalités des composants matériels et logiciels des équipements d'informatique et de télécommunications. L'Internet a été conçu pour pouvoir tirer parti des progrès accomplis dans chacun de ces domaines. Par exemple, les développements techniques qui permettent d'utiliser, en 1999, les objets mobiles (téléphones cellulaires, assistants personnels) ou les télévisions comme terminaux d'accès à l'Internet sont rendus possibles par l'intégration et la baisse des coûts de revient des composants de base de ces matériels. De même, les progrès accomplis dans les technologies de télécommunication permettent d'envisager le déploiement d'infrastructures offrant des bandes passantes supérieures de plusieurs ordres de grandeur à celles qui sont disponibles aujourd'hui.

Composants techniques de l'Internet

Réseaux de transport

L'Internet utilise ou peut utiliser tous les réseaux de télécommunications existants ou à venir. Pour suivre le slogan "IP over everything", Internet bénéficie de tous les progrès technologiques en matière de télécommunications. On a vu ainsi, au fil du temps, apparaître Internet sur le réseau téléphonique (fixe et mobile), l'infrastructure télévision, la fibre optique, les communications satellites, etc. Les infrastructures réseaux sont en général fournies par les opérateurs de télécommunications, leur développement est stimulé par les mesures de dérégulation mises en place à travers le monde. Ces couches basses ne posent pas, à moyen terme, de problèmes majeurs dans les pays industrialisés où l'existant et ce que l'on peut attendre de la concurrence devraient fournir les bases nécessaires au développement technique de l'Internet. A court terme, des différences notables apparaissent cependant, d'un pays à l'autre, en matière de modèle économique, de maturité de la compétition et de réglementation.

Boucle locale

De nombreuses solutions techniques sont en train d'émerger, permettant de choisir la solution appropriée aux problèmes très variés posés par le déploiement local de l'Internet (métropoles, zones industrielles, ..., habitat dispersé) :

- Réseau téléphonique : aucun investissement d'infrastructure nécessaire, nécessite seulement l'équipement du terminal d'accès (en pratique, modem sur PC),

- xDSL : utilise l'infrastructure filaire du réseau téléphonique, nécessite des équipements spécifiques chez l'opérateur et chez l'usager,

- Câble : utilise l'infrastructure du réseau installé pour la télévision, nécessite l'équipement du terminal d'accès,

- Boucle radio : dispense d'une infrastructure filaire, sensible à la géographie, nécessite l'équipement du terminal,

- Boucle GSM : utilise l'infrastructure de téléphonie mobile, nécessite l'évolution du logiciel des téléphones cellulaires,

- Satellites : nécessite le développement d'une infrastructure lourde, fournit une large couverture, nécessite l'équipement du terminal.

L'influence de réglementations conçues avant l'Internet est aujourd'hui particulièrement forte. Les progrès en qualité de service que l'on pourrait attendre des développements techniques sont souvent ralentis par des réglementations peu favorables aux initiatives nouvelles.

Interconnexions

Réseau de réseaux, l'infrastructure de l'Internet se construit grâce aux interconnexions entre les réseaux élémentaires mis en place par les fournisseurs de services ou les grandes organisations disposant de leur propre infrastructure. La topologie de l'Internet, en perpétuelle évolution, est la caractéristique essentielle qui détermine le service rendu, sa qualité, sa performance. Si les questions techniques soulevées par ces interconnexions font l'objet de travaux significatifs pour améliorer les performances, les principaux problèmes à ce niveau tiennent aux modèles économiques pratiqués. Les concepts de "peering" (échange de trafic sans compensation financière) et de "transit" (échange de trafic avec compensation financière) aboutissent à une situation où les fournisseurs de services disposant du plus grand nombre de serveurs "intéressants" sont en situation d'imposer leur "loi économique". Ceci aboutit actuellement à un profond déséquilibre entre les Etats-Unis (où l'on trouve, par exemple, 80% des sites Web) et le reste du monde. Par ailleurs, au fur et à mesure que la capillarité de l'infrastructure technique de l'Internet se densifie, le besoin de développement d'interconnexions locales augmente pour tirer le meilleur parti de la bande passante disponible.

Services d'infrastructure

Bâti sur une infrastructure matérielle, l'Internet est cependant fondamentalement une infrastructure logicielle. En particulier, la plupart des fonctionnalités nouvelles (qui constituent donc des opportunités pour de nouveaux acteurs) peuvent très souvent être fournies grâce à une offre logicielle. Les services indispensables au déploiement réel, c'est à dire à la construction de la société de l'information, sont :

- Connexion et hébergement

- Adressage et nommage

- Annuaires

- Sécurité

- Protection de la vie privée et des données personnelles

- Etiquetage du contenu

Ces services se développent de manière distribuée, indépendamment les uns des autres. Ils contribuent tous, cependant, à augmenter la confiance que l'utilisateur peut avoir envers l'infrastructure Internet.

Equipements

Le déploiement de l'Internet a été à l'origine du développement d'une offre variée de produits. Un marché largement dominé par l'industrie américaine s'est ainsi créé. La valeur ajoutée se trouvant souvent entre le réseau et l'usager final, cette industrie a pris une importance considérable malgré sa jeunesse grâce à son déploiement dans le grand public. Les opportunités existent cependant d'apporter de nouvelles solutions ou fonctionnalités au gré du déploiement de nouvelles applications.

Environnement économique et politique de l'Internet

L'histoire des technologies et de leur impact sur la société a permis de développer un modèle séquentiel où l'idée naît et murit dans un laboratoire, où le transfert de technologie permet à un entrepreneur de développer un produit ou un service, où l'adoption par le marché fait l'objet, enfin, du déploiement commercial. Dans le cas de l'Internet, idée, recherche, prototypage, produits, services, applications et usages s'entremêlent, accélérant la mise au point des produits et leur adoption par les utilisateurs. Cette caractéristique a, bien évidemment, des conséquences essentielles sur le développement technique de l'Internet.

Modèles économiques

Le fait que l'évolution de l'Internet "n'appartient à personne" ou "appartient à tout le monde" pose des questions de type nouveau à ceux qui cherchent à développer une nouvelle activité économique. On a souvent répandu l'idée fausse que l'Internet était gratuit. La vérité est que les modèles économiques font, eux-mêmes, l'objet d'innovations et l'on voit des sociétés majeures changer de modèle économique à plusieurs reprises en quelques années. Sous un autre angle, les relations entre fournisseurs de services en termes d'interconnexion font l'objet de négociations où la créativité est de mise. Enfin, la mise en place des services d'infrastructure (annuaires, nommage, sécurité, protection du consommateur, ...) n'a pas encore trouvé de modèle économique suffisamment convaincant pour permettre le déploiement massif. Ce sont donc non seulement des produits et services qu'il convient d'inventer mais également des mécanismes de marché.

Parmi les questions que l'on peut se poser figurent les arbitrages entre

- tarification au forfait ou au temps,

- abonnements gratuits ou payants,

- équipements (matériels ou logiciels) gratuits (revenus tirés des services) ou payants,

- revenus venant de la publicité ou revenus collectés à la transaction,

- investissements privés ou investissements publics.

Réglementations

Dans un environnement aussi évolutif, la fonction de réglementation est un défi permanent. La jeunesse des technologies pousserait à attendre le déploiement alors que les conséquences sociétales déjà perceptibles poussent à intervenir rapidement. Une attention particulière doit alors être accordée au réalisme des réglementations envisagées. L'Internet étant sans frontière (et donc sans douanes), une législation ne peut être mise en oeuvre sans tenir compte de l'existence ou non de législations dans les autres pays. De plus, la rapidité du déploiement exige des règlements une capacité de passage à l'échelle dont le rythme dépend du marché et non des capacités de l'administration chargée de l'application de la loi. Un soin particulier doit être accordé aux expérimentations avant de finaliser les réglementations. Enfin, le dialogue et la médiation doivent être préférés, à ce stade, à la régulation et à l'application trop directe de règles conçues pour un environnement désormais bouleversé par l'émergence de l'Internet.

Le développement technique de l'Internet est facilité par l'ouverture à la concurrence des télécommunications, désormais largement engagée à travers le monde. Par ailleurs, le rôle d'infrastructure pour la société de l'information associe le développement de l'Internet à d'autres réglementations relatives à des questions aussi variées que

- la cryptologie et ses applications,

- la protection de la vie privée et des données personnelles,

- la protection des droits d'auteurs,

- la protection de la propriété industrielle,

- la protection contre les contenus et comportements illicites.

De manière générale, la construction de l'environnement réglementaire de la convergence est un défi majeur présenté à la communauté internationale. L'Internet a atteint un stade de développement suffisant pour que les interactions entre l'environnement réglementaire et le développement technique constituent désormais un des facteurs décisifs dans la poursuite de la dynamique de déploiement.

Situation en France

Un retard qui s'accroît

Le développement technique de l'Internet en France a pris du retard par rapport aux Etats-Unis mais aussi par rapport à la Grande-Bretagne, l'Allemagne, les Pays-Bas et la Scandinavie, l'Australie ou Hong Kong. Les efforts entamés récemment permettent aux utilisateurs français d'apprécier les bénéfices que l'utilisation de l'Internet peut apporter. Cependant, ces efforts sont insuffisants pour combler le retard accumulé. Par de nombreux aspects, le retard se creuse. Le développement de l'Internet dans les autres pays connaît en effet une accélération nourrie par le déploiement des PC dans les foyers, par la détermination des chefs d'entreprise (souvent encouragés par des tarifs de liaisons avantageux) et par un environnement réglementaire qui met, en première priorité, le déploiement de l'Internet.

Favoriser l'émergence d'un marché européen

L'intégration européenne offre des opportunités nouvelles qui pourraient permettre de combler une partie du retard (par exemple le passage à l'Euro peut être favorable au déploiement du commerce électronique). De plus, l'Europe bénéficie d'atouts dans des domaines (téléphonie mobile, télévision numérique, carte à puces) où l'Internet ne fait que ses premiers pas. Enfin, l'Europe approche l'évolution de la législation relative aux technologies de l'information (directives) de manière coordonnée. Cela peut créer des opportunités de marché pour les services d'infrastructure en particulier (sécurité, protection du consommateur, étiquetage du contenu, ...).

Prendre en compte le développement de l'Internet dans le processus de dérégulation

La dérégulation des télécommunications est une condition nécessaire au déploiement de l'Internet. Cependant, la France, en particulier, et l'Europe, en général, vivent simultanément le développement de l'Internet et le processus de dérégulation des télécommunications. Cette situation n'a pas présidé au développement de l'Internet aux Etats-Unis. Le financement fédéral américain a en effet permis la naissance puis le déploiement de l'Internet dans les milieux académiques, créant une première infrastructure et, surtout, une génération de compétences américaines sans équivalent aujourd'hui en Europe. C'est à partir de cette infrastructure, de ces compétences... et d'une application conçue en Europe, le Web, que l'économie américaine à la recherche d'une nouvelle frontière a entrepris de développer de nouveaux marchés. Si l'Europe et la France se contentent de faire jouer la règle unique du marché au nom du respect de la dérégulation, l'avantage américain est tel que l'écart devrait continuer à se creuser en faveur des nouveaux entrants (MCI WorldCom, Cisco, AOL/Netscape, Yahoo, ...) ou des leaders reconvertis (Microsoft, Sun, IBM, ...).

Aujourd'hui, la priorité opérationnelle donnée à la mise en oeuvre de la dérégulation des télécommunications constitue un frein au déploiement de l'Internet, par exemple dans le développement de la boucle locale (forfait deuxième ligne, usage du câble, déploiement de l'ADSL, ...).

Demain, des questions de même nature se présenteront dans le domaine de l'audiovisuel.

Moteurs du Développement Technique de l'Internet

Applications et Usages

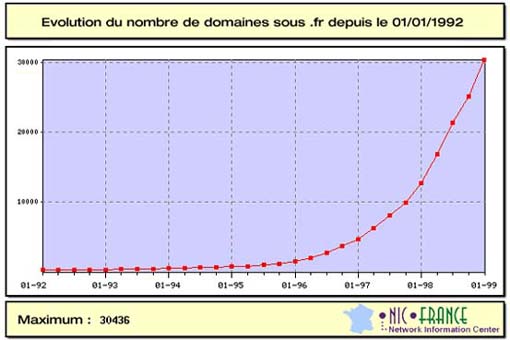

La France a vécu un indiscutable départ en matière d'usage de l'Internet au cours de l'année 1998. Cette évolution encourageante s'est traduite au niveau

- du grand public avec une croissance du nombre d'utilisateurs,

- des entreprises avec une croissance du nombre de sites,

- des administrations avec un ensemble important d'initiatives dans les domaines de l'éducation, de la culture, de la santé, des relations administration-citoyen.

Cependant, cette évolution permet seulement de maintenir l'écart avec les autres pays européens (Grande-Bretagne, Allemagne et Scandinavie). Le fossé se creuse avec les Etats-Unis où la généralisation des usages a créé une dynamique sans équivalent dans le monde.

Cette situation a pour conséquence de rendre de plus en plus importante la dépendance technologique (achat de produits américains) et culturelle (adoption des paradigmes d'usages américains).

Technologies et Standards

L'Internet est encore dans sa phase d'"adolescence" et de très nombreux développements sont en cours dans le monde pour généraliser son positionnement comme infrastructure de la société de l'information. Le développement de ces nouvelles technologies est conduit par des organisations souvent créées à partir d'initiatives américaines.

La participation effective de la France à ces travaux est encore largement insuffisante malgré certains résultats significatifs tels que la position des chercheurs français dans le développement d'IPv6 ou l'hébergement à l'INRIA de la composante européenne du W3C. Si la recherche publique française est présente dans les travaux de l'IETF, du W3C, ..., la participation industrielle est trop insuffisante pour envisager un retour proche dans le peloton de tête des pays qui influent sur l'évolution technique de l'Internet.

Cette évolution technologique est concomitante avec le développement des standards. Le paradigme de conception de nouvelles fonctionnalités adopté par l'IETF et repris par W3C demande à chaque nouvelle spécification la preuve de deux mises en oeuvre interopérables pour que celle-ci puisse prétendre au rang de standard ou de recommandation. Cette vision très opérationnelle du développement de standards donne aux pays disposant de la maîtrise technologique un effet de levier exceptionnel.

La France (à l'exception notable des centres de recherche publics) a trop longtemps ignoré les technologies et standards de l'Internet pour disposer aujourd'hui de cette maîtrise technologique. L'appel à propositions 1999 du RNRT (Réseau National de Recherche en Télécommunications) propose d'engager une action spécifique pour susciter des projets de recherche et développement.

Des opportunités apparaissent par ailleurs au moment où la convergence des technologies de l'information demande à la communauté technique de l'Internet de s'ouvrir à d'autres domaines tels que la téléphonie mobile ou l'audiovisuel. Les positions plus fortes de la France et de l'Europe dans ces domaines peuvent être exploitées si les communautés acceptent de s'investir dans les travaux des organisations internationales compétentes.

Composants techniques de l'Internet

Réseaux de transport

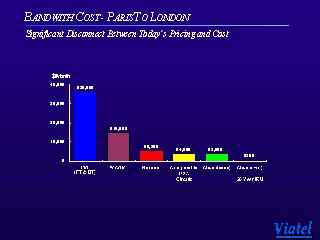

La France bénéficie d'un réseau de télécommunications moderne. Par ailleurs, la concurrence engagée à la suite des mesures de dérégulation permet d'envisager la multiplication de l'offre et une baisse des coûts. Enfin, la concurrence joue également pour les liaisons vers l'étranger. L'Internet peut donc s'appuyer en France sur une infrastructure compétitive. Les investissements importants consentis devraient permettre que cette infrastructure demeure au meilleur niveau mondial. Il reste que les modèles économiques utilisés tardent à évoluer et que les tarifs pratiqués (pour les lignes louées par exemple) sont encore trop élevés pour permettre le déploiement d'une offre présentant, à un prix donné, des débits comparables à ceux disponibles dans les pays les plus avancés, aux Etats-Unis, en particulier, où la concurrence joue à plein.

Boucle locale

La variété des solutions techniques appelle des initiatives diversifiées pour acquérir une maîtrise technologique aujourd'hui insuffisante et une compréhension de l'éventail des possibles. La complexité des réglementations et la multiplicité des organes de régulation impliqués limitent la mise en place des expérimentations indispensables. Dans ce contexte, les collectivités locales ont du mal à exercer leur rôle. Le retard de la France se creuse sur ce domaine difficile et critique pour le déploiement généralisé de l'Internet pour tous.

Interconnexions

Le dispositif d'interconnexion doit être observé à trois niveaux : national, local et international.

Niveau national

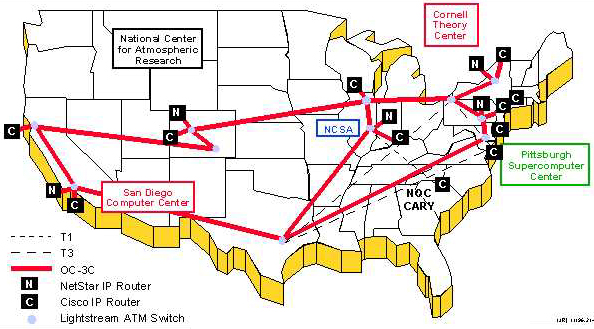

Comme dans tous les pays, les premiers éléments de l'infrastructure Internet ont été mis en place sous la responsabilité du réseau national de l'enseignement et de la recherche, en France Renater. C'est ainsi que le GIX (point d'interconnexion national) permet encore, en 1999, aux fournisseurs de service Internet de mettre en place leurs politiques d'interconnexions. Géré par Renater pour des raisons historiques, le GIX n'a pas vocation à être l'unique point d'interconnexion national. Un deuxième point d'interconnexion national, PARIX, a été ouvert en 1998 par France Telecom.

Niveau local

La capillarité de l'Internet en France atteint à peine le niveau qui justifie économiquement le déploiement de points d'interconnexion locaux. De plus, les initiatives locales de nature publique (par exemple métropole régionale), ne sont pas encouragées par les conditions imposées par la dérégulation. Un seul point d'interconnexion régional a été mis en place, à Grenoble.

Niveau international

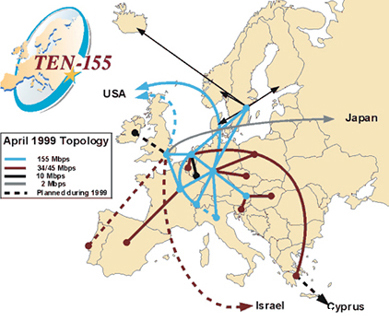

Les connexions européennes, américaines et internationales, en général, sont bien sûr particulièrement importantes puisque l'Internet est une infrastructure mondiale. La jeunesse de l'offre de services sur le territoire national rend les termes de l'échange défavorables pour les fournisseurs d'accès nationaux. Par exemple, Renater est devenu inutilisable, en 1996-1997, lorsque la demande d'accès aux sites américains s'est soudainement développée. La situation s'est largement améliorée depuis 1998 grâce à des investissements supplémentaires et à la baisse des prix issue de la concurrence. Des efforts additionnels sont cependant indispensables pour permettre à la communauté nationale de disposer d'un environnement comparable à celui de ses pairs à travers le monde. Enfin, les connexions européennes présentent, à leur échelle, des caractéristiques d'insuffisance en termes de densité d'interconnexions.

Services d'infrastructure

-

Connexion et hébergement

Ces services sont largement couverts par le marché et sont en forte croissance depuis 1998.

-

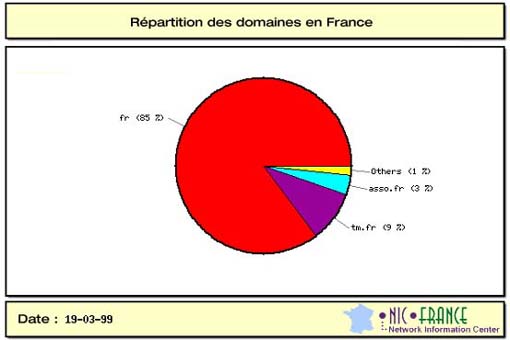

Adressage et nommage

Le rôle de l'AFNIC est désormais reconnu par la communauté. La place de la France dans les discussions autour de l'ICANN a été significative.

-

Annuaires

Le marché joue le rôle important. L'avance prise par les sociétés américaines est un exemple de l'avantage acquis par la présence initiale sur le marché. La particularité des sites francophones donne une chance à des offres françaises.

-

Sécurité

L'annonce de la modification de la loi sur la cryptologie a eu un effet très positif sur la reconnaissance internationale que la France est déterminée à prendre sa place sur l'Internet. Ceci crée des opportunités de marché qui sont à saisir. Ceci crée aussi un devoir de diligence dans l'établissement des règles d'application de la loi. Le retard dans la détermination et la publication de ces règles pourraient rendre difficile leur application concrète (situation de fait accompli).

-

Protection de la vie privée et des données personnelles

L'expérience de la CNIL et la disponibilité de la directive européenne fournissent les bases d'une politique encore à mettre en oeuvre.

-

Etiquetage du contenu

La lenteur du déploiement des bureaux d'étiquetage donne le temps nécessaire à l'établissement d'une politique.

Equipements

Le marché des équipements est bien entendu mondial. Il s'agit d'un marché en très forte évolution où les opportunités sont nombreuses. L'avance prise par le marché américain est telle que toute initiative prise par une société européenne doit être confrontée au déploiement aux Etats-Unis pour accéder aux volumes nécessaires à la rentabilité. Il reste que des compétences acquises peuvent être mises à profit pour construire des offres originales (cartes à puce, terminaux intelligents par exemple).

Environnement économique et politique

Modèles économiques

Le retard en France s'explique, en partie, par l'application directe de modèles économiques hérités du monde des télécommunications.

-

tarification au forfait ou au temps

L'usage du réseau téléphonique comme accès local induit une facturation de l'accès à l'Internet dépendante du temps. Si la boucle locale est fournie par le câble ou l'ADSL, la facturation est forfaitaire. Aux Etats-Unis, au Canada, en Australie, la communication téléphonique est facturée au forfait. Cette situation, si elle a conduit parfois à des excès, a eu un effet décisif dans l'adoption de l'Internet par le grand public. L'annonce de l'offre "forfaitaire" de France Telecom (limitée à vingt heures par mois), en mai 1999, est un premier pas encore insuffisant dans cette direction.

-

abonnements gratuits ou payants

Au deuxième trimestre 1999, plusieurs offres d'abonnements gratuits sont apparues. Cette approche est bien adaptée aux usages limités dans le temps. La gratuité ne porte, en effet, que sur l'abonnement forfaitaire et la facturation au temps de la communication téléphonique locale est maintenue.

-

équipements (matériels ou logiciels) gratuits (revenus

tirés des services) ou payants

Comme pour le minitel à son lancement, la mise à disposition gratuite de terminaux est une pratique en cours d'expérimentation.

-

revenus venant de la publicité ou revenus collectés à la

transaction

De même que le modèle économique issu des services téléphoniques prévaut aujourd'hui pour la boucle locale, les modèles issus de l'audiovisuel ont été transposés aux services disponibles sur l'Internet (en particulier le financement par la publicité). Il est clair que, dans ce cas, le retard en matière d'usage grand public en France se traduit par un retard en capacité de financement selon ce modèle. D'autres modèles sont à l'étude dans le monde. La pratique courante de la carte à puce, en France, est certainement un atout au moment d'envisager des modèles économiques alternatifs.

-

investissements privés ou investissements publics

La faiblesse des investissements publics et privés sur l'Internet dans les vingt dernières années a des conséquences de toutes natures. Il convient de se poser la question de mesures exceptionnelles pour combler les retards. On peut, en guise de référence, étudier les investissements publics massifs déployés aux Etats-Unis AVANT de transférer au marché la responsabilité du déploiement généralisé ainsi que ceux mis en place pour les cinq années à venir au niveau du financement public de la recherche en technologies de l'information (croissance d'un milliard de dollars en cinq ans).

Réglementations

Le développement technique de l'Internet se heurte à un ensemble de réglementations développées pour le domaine des télécommunications ou de l'audiovisuel. Ces réglementations n'ont pas pris en compte, lors de leur conception, les bouleversements que l'Internet engendre. Cette situation n'est pas propre à la France. Tous les pays sont confrontés au défi d'adapter leurs règles à la situation nouvelle ainsi créée. Il reste que la flexibilité dont chaque pays fera preuve sera un élément déterminant de la place que le pays occupera dans le déploiement de l'Internet et donc de la société de l'information.

Recommandations

Les pouvoirs publics ont fait du développement de l'Internet une priorité pour l'entrée de la France dans la société de l'information. Toutefois, comme l'évolution et le déploiement de l'Internet s'effectuent de manière essentiellement décentralisée, la place des pouvoirs publics est délicate à préciser et doit relever d'un positionnement original. Par exemple, les idées de "plan" ou de "gouvernance" doivent être laissées de côté en faveur d'une approche reposant sur

- l'exemplarité plutôt que l'autorité,

- la médiation plutôt que la régulation,

- l'investissement public sélectif pour faciliter la généralisation des investissements privés.

En tout état de cause, le succès ne viendra qu'avec l'engagement des forces du marché et l'adoption par les entreprises et le grand public.

***

Les recommandations sont formulées pour atteindre trois objectifs.

Créer des produits et services

L'Internet est encore largement un domaine d'opportunités. La création de nouveaux contenus et de nouveaux services est ouverte aux initiatives nouvelles. Pour participer de manière significative au développement technique de l'Internet, il faut également être présent aux endroits où l'Internet de demain se conçoit.

Construire la confiance

La confiance des utilisateurs implique la satisfaction de besoins essentiels (sécurité, respect de la vie privée, ...). Les logiciels et services d'infrastructure doivent permettre de répondre à ces besoins. Pour les opérateurs techniques (opérateurs de télécommunications, fournisseurs d'accès, hébergeurs, ...), le manque d'informations quantitatives sur le fonctionnement de l'Internet (qualité de service, trafic, applications utilisées, ...) rend difficile le dimensionnement de leur offre. Le développement d'un réseau d'observatoires doit permettre de remédier à cette situation. Enfin, l'évolution de l'environnement réglementaire doit être adapté pour lever les incertitudes nées de l'émergence de l'Internet.

Augmenter les performances

Les efforts sur la boucle locale sont prioritaires pour offrir, à court terme, un accès performant aux utilisateurs. Dès que le déploiement de nouvelles boucles sera engagé, les interconnexions locales devront progresser pour optimiser l'acheminement des contenus de proximité. Enfin, le déploiement d'applications audiovisuelles demandera l'évolution de l'infrastructure du réseau de transport (accroissement des bandes passantes, adaptation des protocoles).

Moteurs du Développement Technique de l'Internet

Applications et Usages

Favoriser le développement

- des applications auteurs (logiciels de conception et de gestion de sites, ...)

- des applications de la convergence (logiciels de téléphonie et vidéo sur IP, ...)

Développer les formations d'enseignement supérieur

- aux technologies logicielles et matérielles de l'Internet

- à l'administration des réseaux et des sites

- à la création et à l'utilisation des services

Technologies et Standards

Enrichir la culture de l'Internet et des technologies de la convergence

- Donner la priorité aux technologies de l'Internet dans le financement public des efforts de recherche

- Créer une fondation pour le développement de logiciels libres

- Favoriser la prise en compte des dimensions économique et sociale dans le développement technologique par l'organisation d'échanges pluridisciplinaires

- Renforcer la participation française aux organismes de standardisation (IETF, W3C) et aux manifestations scientifiques internationales

Composants techniques de l'Internet

Réseaux de transport

Permettre la recherche et le développement de nouvelles applications par

- le lancement d'une version nationale de l'Internet du futur

- le développement de réseaux régionaux métropolitains

Boucle locale

Favoriser l'utilisation de toutes les technologies

- Réseau téléphonique : Permettre l'utilisation d'une deuxième ligne, dédiée à Internet, à des conditions favorables

- ADSL : Accélérer le déploiement en créant les conditions d'un marché concurrentiel

- Câble : Créer les conditions d'une exploitation efficace de l'infrastructure existante

- Boucle locale radio : Encourager les expérimentations et le déploiement

- Permettre aux collectivités territoriales de participer à la création de réseaux à haut débit pour l'accès à Internet

Avec pour objectif de généraliser, à terme de cinq ans, les accès locaux avec les performances suivantes :

- Grand Public : >1 Mbit/s

- PME : >10 Mbits/s

- Grandes Entreprises : >100 Mbits/s

Interconnexions

Développer une culture de l'interconnexion Internet en encourageant la transparence

- Créer un observatoire pour mesurer l'état des infrastructures Internet en temps-réel (trafic, points de congestion, ...)

- Organiser la certification des procédures d'interconnexion des couches basses

- Encourager la mise en place de points d'interconnexion locaux pour optimiser l'architecture du réseau

- Contribuer à l'amélioration des interconnexions au niveau européen

Services d'infrastructure

Construire la confiance en s'appuyant sur la décentralisation des responsabilités

Connexion et hébergement

- Encourager l'élaboration et la diffusion d'indicateurs de qualité pour les services de connexion et d'hébergement sur Internet

Adressage et nommage

- Créer une autorité de certification des sites afin de garantir l'identification des sources d'information et de services

Sécurité

- Mettre en place des autorités de certification gérées par des administrations et des organismes publics

- Mettre en place une structure d'échange et de coordination chargée de l'information sur les risques et alertes

Protection de la vie privée et des données personnelles

- Lancer dans l'administration française des plateformes expérimentales conformes aux modalités de la directive européenne et de la future loi

Etiquetage du contenu

- Encourager le développement de systèmes d'étiquetage "positif" dans un but pédagogique

- Encourager l'étiquetage déclaratif du contenu auprès des fournisseurs d'information

Equipements

Mettre l'accent sur les atouts, éliminer les freins

- Utiliser le savoir-faire français en commerce électronique (services et terminaux intelligents, carte à puce)

- Favoriser l'émergence et le succès des sociétés de haute technologie par un environnement attractif

Environnement économique et politique

Modèles économiques

Permettre la coexistence de modèles économiques différents

- Encourager la concurrence des différents modèles économiques sur la boucle locale (tarification forfaitaire ou au temps pour l'accès à Internet, ...)

- Assurer la transparence des prix de transport

- Encourager la variété des modèles économiques pour les services (publicité, paiement à la transaction, ...)

Réglementations

Reconnaître l'Internet comme la plateforme de la convergence entre l'informatique, les télécommunications et l'audiovisuel

- Etablir un cadre réglementaire intermédiaire (pour une période de cinq ans) pour favoriser les expérimentations

- Donner la priorité à la médiation plutôt qu'à la régulation

- Construire un environnement législatif adapté à la convergence