Conçu à l'origine pour établir efficacement des flux de données entre des ordinateurs distants, l'Internet s'est développé en fonction de l'évolution des besoins et de la technique pour constituer maintenant une infrastructure complexe où les mécanismes de transports de l'information sont enrichis par des services d'infrastructure qui permettent :

- la connexion au réseau des terminaux et des serveurs ("Connexion et hébergement"),

- la désignation et la localisation des ressources disponibles ("Adressage et nommage" et "Annuaires"),

- la sécurisation des communications et des informations ("Sécurité"),

- la maîtrise des informations par l'utilisateur ("Protection de la vie privée et des données personnelles"),

- la classification des informations accessibles ("Etiquetage du contenu").

La mise en oeuvre de ces services nécessite la mise en place de mécanismes et de protocoles sur les terminaux, les serveurs de contenus et les serveurs techniques de médiation et, en général, ne requièrent pas de modification profonde des mécanismes réseau sous-jacents.

Contexte international

Une architecture fortement distribuée

Connexion et hébergement

Première étape dans l'accès au réseau mondial, le Fournisseur d'Accès à l'Internet (FAI) est souvent le médiateur obligé vers l'ensemble des services disponibles sur le réseau et, à ce titre, a certaines obligations aux yeux de ses clients et utilisateurs :

- la fourniture de mécanismes d'accès optimisant les possibilités du support utilisé pour la connexion (réseau téléphonique commuté analogique ou numérique, accès ADSL, câble, réseaux radio, satellites) notamment en termes de capacité de transfert d'information (utilisation optimale de la bande passante disponible),

- la disponibilité de l'accès et l'optimisation des coûts de connexion obtenues par la multiplication et le dimensionnement correct des points d'accès,

- le dimensionnement correct de ses liens vers les réseaux constituant l'Internet pour éviter des goulots d'étranglement et une réduction visible des performances pour l'utilisateur,

- une infrastructure informatique performante et optimisée (serveurs de noms, de messagerie ou de forums, mise en place éventuelle de caches, ...),

- la garantie d'un bon niveau de sécurité empêchant les fraudes, notamment dans le cas d'accès Internet non forfaitaires, la protection des informations,

- une exploitation et une assistance permanentes, une aide à la maîtrise des techniques utilisées, une bonne réactivité aux incidents,

- la mise à disposition (en général de façon permanente pour les entreprises et temporaire pour le grand public) d'adresses IP associées éventuellement à un nom de domaine,

- la transparence vis à vis des différents protocoles de l'Internet pour l'utilisation éventuelle d'applications fournies par des tiers.

L'ensemble de ces paramètres constitue la qualité de service (en anglais QoS, Quality of Service) visible par l'utilisateur, qu'il soit une personne voulant naviguer sur le Web ou une entreprise voulant mettre en place des serveurs. Conformément à la philosophie de l'Internet, cette qualité de service est rarement contractuelle dans le cas des accès ouverts pour le grand public, des professionnels ou des PME : le fournisseur d'accès est certes tenu de faire de son mieux (concept du meilleur effort caractéristique des protocoles Internet : en anglais, Best Effort) mais il s'agit tout au plus d'une obligation de moyens qui n'est pas toujours facilement mesurable. Il peut donc exister des situations contrastées entre les différents FAI.

La mise en place d'un serveur d'informations sur Internet au niveau d'un particulier, d'une entreprise, d'une administration ou d'une organisation peut se faire de deux façons : le raccordement direct et permanent d'un de ses serveurs sur l'Internet (en utilisant éventuellement un coupe-feu pour garantir la sécurité) ou l'hébergement du service sur un serveur fourni par un tiers (soit le fournisseur d'accès, soit un prestataire spécialisé dans ce genre de service).

Adressage et nommage

Une gestion planétaire à mettre en place

Le réseau Internet lui-même ne connaît les machines et ressources qui s'y raccordent que par une adresse numérique du type "192.134.0.0" : ces adresses sont utilisées par les machines constituant le réseau (routeurs) pour transmettre les paquets d'information à leur ordinateur de destination. En théorie, toutes les machines pouvant communiquer sur Internet devraient avoir une adresse différente : en pratique, de nombreuses machines, n'accédant à Internet qu'à partir d'intranets (réseau privé fermé exploitant les techniques Internet et utilisé par une entreprise, un organisme, une administration...), il peut y avoir plus de machines que d'adresses disponibles. Toutefois, en attendant la prochaine version du protocole IP, IPv6 et son système d'adressage étendu, les adresses Internet sont des ressources rares considérées comme un bien public à gérer équitablement. La gestion des adresses au niveau mondial se fait sous le contrôle de l'IANA qui la délègue à des organismes régionaux comme le RIPE (Réseaux IP Européens) pour l'Europe qui à son tour la délègue à des fournisseurs d'accès et des opérateurs de réseaux nationaux. Une entreprise ou un particulier désirant se raccorder à Internet doit donc demander une adresse parmi les adresses gérées par son fournisseur d'accès. Cette adresse est en général allouée pour une durée limitée à la session courante dans le cas des connexions grand public ; elle doit être fixe dans le cas d'une entreprise désirant rendre accessible par l'Internet un serveur d'information.

Pour faciliter l'accès via l'Internet aux serveurs et ordinateurs, les concepteurs du réseau y ont introduit un mécanisme de désignation hiérarchique qui organise les ressources en domaines et qui conduit à des noms plus faciles à manipuler ("internet.gouv.fr" par exemple) que des suites de chiffres. Ces noms sont notamment utilisés pour référencer les pages Web au moyen d'URL ("http://www.internet.gouv.fr/francais/index.html" par exemple). Au sommet de la hiérarchie des domaines se trouvent les domaines primaires (TLD Top Level Domain) qui partitionnent les ressources selon leur rattachement national (domaine ".fr" pour la France par exemple) ou selon leur type (par exemple, ".com" pour les entreprises, ".net" pour les organismes liés à l'Internet, même si "www.internet.net" renvoie sur une société de commerce en ligne !). Le nom d'un site est indépendant de sa situation géographique et du fournisseur d'accès par lequel il est connecté à l'Internet. La traduction entre un nom de domaine et une adresse réseau est effectuée par des serveurs situés "en périphérie" du réseau, les serveurs de noms de domaine (en anglais DNS : Domain Name Service).

L'organisation de ces domaines, après avoir longtemps été gérée par l'IANA, un organisme sous financement fédéral américain, est désormais gérée par l'ICANN, une organisation aux statuts et aux membres plus internationaux, solution encouragée par les pouvoirs publics de nombreux pays dont la France. Chaque TLD est géré par un organisme ou une entreprise chargés d'allouer les noms, de les enregistrer dans les serveurs DNS et d'exploiter ces serveurs.

Le domaine ".com" par exemple est réservé à la présence sur l'Internet des entreprises commerciales et compte un peu moins de 3 millions de noms (en février 1999 - source AFNIC, Association Française pour le Nommage Internet en Coopération). Il est administré par l'InterNIC (géré pour l'instant par NSI, société commerciale américaine mais en cours de mise en concurrence par ICANN), qui alloue les noms au fur et à mesure des demandes sans vérifier la légitimité des demandeurs (légitimité d'ailleurs très difficile à établir dans un contexte international).

Des propositions ont été faites en 1998 pour augmenter le nombre de TLD et donc limiter le nombre de conflits sur les noms mais elles ne sont pas encore opérationnelles. Il faut noter que les procédures d'attribution des noms basées sur l'antériorité des demandes ne suivent pas les règles nationales ou internationales destinées à protéger les marques : cela entraîne des collisions de noms (fortuites ou intentionnelles) dont la résolution (à l'amiable ou devant les juges) pénalise les acteurs concernés. L'évolution technique des mécanismes de navigation (par exemple ceux s'adaptant aux préférences de l'utilisateur ou utilisant des requêtes en langue naturelle), l'usage systématique des moteurs de recherche et des annuaires, ainsi que les initiatives telles que RealNames, sont de nature à rendre moins visibles à l'utilisateur les adresses (URL) des sites Web qu'il consulte et donc à rendre moins stratégique le choix des noms de domaines.

Annuaires

Pour faciliter les usages

Annuaires de services

Les mécanismes de nommage, même s'ils évoluent, ne permettent pas, à eux-seuls, une navigation rapide et efficace dans la masse d'informations accessibles par Internet et en particulier par le Web. L'utilisateur, qu'il recherche une information précise ou qu'il navigue pour son plaisir, a besoin d'outils et de services pour l'assister dans ses tâches : ce besoin a été identifié très tôt, avant même l'existence du Web (serveurs Archie pour les sites FTP, protocoles et serveurs WAIS, ...) et la croissance du médium s'est accompagnée par une importance de plus en plus grande prise par les services (portails) pouvant servir de points d'entrée et de redirection vers l'ensemble du Web. Permettant une recherche des sites par mots clés (moteurs de recherche), offrant une classification rationnelle et hiérarchique des services et intégrant de plus en plus des informations d'actualité, ils utilisent en général des systèmes parcourant automatiquement l'Internet de façon aussi exhaustive que possible pour télécharger les pages d'information, les indexer automatiquement ou les faire classifier par des équipes spécialisées. Ces portails, opérant à la périphérie du réseau, sont parmi les sites les plus consultés : ils louent des espaces publicitaires très prisés, ce qui entraîne une forte concurrence (entre eux et avec les sites des principaux fournisseurs de services) et des convoitises (acquisition par d'autres acteurs). Pour un site Web, être référencé par les portails est la première démarche d'une publication Internet réussie : il est possible en une seule opération (en général payante) de faire référencer automatiquement un site par de nombreux moteurs de recherche.

Annuaires de personnes

Il est très facile sur l'Internet de se créer une boîte à lettres électronique : les fournisseurs d'accès en offrent systématiquement une ou plusieurs et de nombreux sites proposent l'ouverture de boîtes gratuites. Etant donné que, contrairement aux réseaux téléphoniques, les fournisseurs ne proposaient pas systématiquement des annuaires, cette fonctionnalité a été développée par des entreprises indépendantes qui recueillent les inscriptions volontaires de possesseurs de boîtes à lettres ou collectent des adresses par divers moyens et permettent, grâce à des protocoles spécialisés (LDAP) ou des services de recherche, de retrouver l'adresse électronique d'un correspondant potentiel. Ces sociétés sont en général associées à des moteurs de recherche généraux.

Sécurité

Un facteur essentiel de la confiance

Pour jouer pleinement le rôle de véritable système nerveux des sociétés où il se déploie, l'Internet se doit de devenir une infrastructure de communication fiable et inspirant la confiance à tous ses utilisateurs. Son caractère fortement distribué, son passé de réseau de la recherche mondiale, son ouverture et sa transparence technique, l'existence de quelques failles et incidents médiatisés ont fait qu'il est considéré comme moins fiable et moins mûr que d'autres réseaux de télécommunications (réseau téléphonique, réseau de télex, réseaux télématiques...). Pour établir la confiance propre à développer une large utilisation de l'Internet notamment pour le commerce électronique (voir sur ce sujet le rapport Lorentz), il faut d'une part limiter les risques de perturbations touchant le réseau et son infrastructure (pour préserver son intégrité et sa capacité à fonctionner), d'autre part sécuriser les échanges utilisant l'Internet (pour accéder à de l'information, pour communiquer, pour acheter/vendre des biens et des services).

Intégrité des réseaux

Quelques facteurs contribuent à l'amélioration de la sécurité de l'infrastructure Internet :

- une plus grande maturité des opérateurs d'accès, de réseaux et de services résultats d'un savoir-faire collectif en constante amélioration (meilleure compréhension des phénomènes, apprentissage par l'expérience, amélioration des systèmes techniques...),

- la mise en place de mécanismes et de structures permettant de mieux gérer la nature plurielle de l'Internet et sa complexité : protocoles permettant un meilleur comportement global du réseau et une meilleure robustesse, mise en place de réseaux officiels ou informels entre les acteurs pour détecter les dysfonctionnements ou les attaques et organiser les ripostes,

- le déploiement de systèmes techniques permettant de préserver l'intégrité des réseaux et des services : le cloisonnement des flux d'information permettant de limiter les risques (utilisation de réseaux de transport redondants, mise en place de réseaux privés virtuels), la mise en place d'équipements de médiation appelés coupe-feu pour sécuriser les serveurs hébergeant les informations, l'étude de nouveaux protocoles intégrant mieux la sécurité (par exemple les mécanismes d'IPv6 et IPSEC).

Toutefois, les risques sont toujours présents : actions malveillantes pour s'emparer d'informations, scénario d'attaques organisées dans le cadre de guerres par réseaux interposés, actions entraînant un déni de service, réactions en chaîne propageant des erreurs, virus informatiques (Note : les virus informatiques ne sont pas propres à l'Internet mais son utilisation augmente très fortement les possibilités de dissémination). Sont visés non seulement les réseaux eux-mêmes, au travers de leurs liaisons ou de leurs équipements, mais surtout la multitude d'ordinateurs directement connectés à l'Internet et dont toute faille est facilement exploitable à distance. L'Internet offre certainement un magnifique outil de communication au service d'individus ou d'organismes mal-intentionnés : de nombreux sites proposent sur le Web divers moyens pour tirer parti des failles de sécurité de l'Internet (comme celles des autres réseaux ou systèmes techniques d'ailleurs !).

Les outils Internet sont heureusement aussi mis à profit pour contrer et prévenir ces actions menaçant l'intégrité des réseaux : ainsi, un certain nombre d'associations ont été mises en place (principalement au sein des agences fédérales ou des universités américaines, dont la plus connue est le CERT Coordination Center) qui relaient en permanence sur leurs sites Web et par des listes de diffusion des informations pertinentes sur l'existence de nouvelles menaces. Elles sont capables d'organiser une éventuelle réaction à un incident ou une attaque. Ces pratiques ont été reprises par d'autres organisations dans d'autres pays et se sont regroupées au sein d'une structure de coordination (FIRST). De plus, les opérateurs majeurs ont tous des équipes d'exploitation chargées de surveiller en permanence le fonctionnement de leurs réseaux et de ceux de leurs clients. Ces équipes sont à même d'intervenir en cas d'alerte et éventuellement se coordonner pour réagir.

Sécurité des personnes et des biens

Au delà du maintien de l'intégrité des ressources matérielles et logicielles qui composent la nébuleuse Internet, il faut s'assurer que son utilisation comme outil de communication, de négociation, de transaction ou d'information n'engendre pas des risques importants pour les personnes et les biens, risques qui, s'ils étaient mal gérés, pourraient avoir un effet négatif sur les usages et donc freiner l'adoption d'Internet comme l'une des bases de la société.

Les principaux risques sont des transpositions dans un monde numérique de risques classiques (vols de biens et de services, usurpation d'identité, accès à des informations confidentielles, atteinte à la vie privée, fraudes en tout genre, crimes...) agravés par le fait que les législations et les appareils judiciaires n'ont pas toujours pleinement intégré l'impact des nouvelles technologies de l'information et de la communication.

Les solutions techniques universellement proposées sont principalement basées sur l'utilisation de mécanismes de cryptologie garantissant l'identité des utilisateurs (authentification) et des services (certification des serveurs par des tiers), l'origine et l'intégrité des informations échangées (signature électronique) ainsi que leur confidentialité (chiffrement des informations et des communications). Un certain nombre d'algorithmes et de protocoles sont largement diffusés (DES, IDEA pour les clés secrètes, RSA pour les clés publiques, Diffie-Hellman pour l'échange de clés, X509 pour la diffusion de certificats, TLS-SSL pour la sécurisation des sessions, S-MIME pour le chiffrement du courrier électronique) et intégrés dans les logiciels tels que les serveurs Web et les navigateurs : ils sont déjà utilisés pour les communications interpersonnelles, la consultation d'information, le commerce électronique et l'accès aux systèmes d'information des entreprises et des administrations.

Le chiffrement des communications et des informations pouvant être utilisé pour échapper à la justice ou pour attenter aux souverainetés nationales, les gouvernements peuvent désirer en restreindre ou en contrôler l'utilisation et l'exportation, en général en fixant des seuils à ne pas dépasser pour la taille des clés utilisées. La mise à jour des accords de Wassenaar de décembre 1998 a conduit à uniformiser les pratiques à l'exportation entre les pays industrialisés (exportation autorisée tant que les clés secrètes restent inférieures à 56 bits).

Protection de la vie privée et des données personnelles

La protection de la vie privée et des données personnelles sur Internet est contraire aux modèles économiques des éditeurs d'information : ces éditeurs ont tout intérêt à récupérer le maximum d'informations sur leurs visiteurs et à en tirer pécuniairement parti, par exemple en valorisant la fréquentation de leur site (volume, ciblage...) auprès des publicitaires, ou en louant et vendant les fichiers d'informations recueillies sur leurs visiteurs. Pour cela, les logiciels Internet intègrent des techniques qui permettent aux éditeurs de collecter des données, souvent à l'insu des consommateurs : les cookies. Toutefois, ce principe des cookies est sérieusement contesté par les associations de défense des consommateurs et des droits de l'Homme, et enfreint souvent les lois sur la protection des données personnelles en vigueur dans de nombreux pays.

Les législations en vigueur sont très différentes selon les régions du monde. Elles sont inexistantes aux Etats-Unis où seul le principe d'auto-régulation fait foi. Les acteurs économiques maintiennent une pression constante sur le gouvernement fédéral pour prévenir toute velléité de législation dans le domaine. De façon plus positive, IBM a annoncé le 31 mars 1999 qu'il retirerait à partir de juin 1999 toutes ses publicités sur les sites qui n'afficheraient pas de politique claire en matière de protection de la vie privée. En Europe, le principe de législation fait foi, et la directive du 24 octobre 1995 concernant la protection de données personnelles est en vigueur depuis le 25 octobre 1998. Cette directive vise à réduire les divergences entre les législations nationales, et elle est actuellement en cours de transposition dans l'Union Européenne. Fin 1998, la Grèce, le Portugal, la Suède, le Royaume-Uni et l'Italie ont mis en oeuvre la directive. Des lois de transposition sont à l'étude devant les Parlements de tous les autres états membres, exceptés l'Allemagne, la France et le Luxembourg, qui ont un travail plus lourd de modification d'un cadre réglementaire déjà bien établi.

Il y a donc une différence d'approche radicale entre les systèmes législatifs comme ceux préconisés en Europe et le système d'auto-régulation préconisé par les Etats-Unis, où seules des réglementations sectorielles et très limitées donnent un cadre législatif. Pour permettre l'implémentation de ces différentes politiques de protection de la vie privée selon les régions du monde, le W3C a lancé l'initiative P3P (Platform for Privacy Preferences Project) en mai 1997. Cette initiative vise à permettre aux utilisateurs de sites Web de choisir explicitement le niveau d'information qu'ils désirent fournir aux sites qu'ils consultent. Actuellement à l'état de "draft", les spécifications de P3P devraient accéder au statut de recommandation mi-1999. Début 1999, il n'y a pas encore d'implémentation disponible ni annoncée par les fournisseurs de logiciels Web.

Etiquetage du contenu

L'étiquetage du contenu des pages Web est né du besoin exprimé en 1995 par des parents et des professeurs de contrôler l'information à laquelle les enfants ont accès à travers l'Internet. Un système nommé PICS (Platform for Internet Content Selection) a été spécifié dans un groupe de travail du W3C, permettant la conception de systèmes d'étiquetage (catégories et valeurs dans chaque catégorie) et de logiciels de filtrage des pages étiquetées. PICS permet de définir des étiquettes significatives pour un usage donné, d'étiqueter son propre site ou le site d'un tiers, et de filtrer l'information étiquetée de façon positive (sélection) ou négative (blocage), par un logiciel individuel (navigateur) ou par un logiciel collectif (coupe-feu, proxy...).

Début 1999, on est encore à l'aube de l'étiquetage du contenu. Peu de systèmes d'étiquetage sont déployés. Les plus populaires sont RSACi, SurfWatch et Safesurf. Peu de logiciels de filtrage sont disponibles, principalement le navigateur de Microsoft depuis la version 3 et celui de Netscape depuis la version 4.5. Quelques logiciels de filtrage à usage collectif (serveurs, proxies...) ont été développés à titre expérimental uniquement. La raison principale de cette désaffection est sans doute la difficulté rencontrée jusqu'à présent pour concevoir un modèle économique faisant usage de l'étiquetage du contenu.

Au niveau conceptuel, le contrôle parental a été la première expression d'un besoin plus général pour un mécanisme permettant l'interprétation de documents Web par des machines (moteurs de recherche, navigateurs, agents intelligents...). Un langage nommé RDF (Resource Description Framework), permettant de décrire un document Web par des métadonnées (des données facilement interprétables par des machines), est en cours de définition au W3C. RDF est la généralisation du système PICS à bien d'autres applications que le contrôle parental. Compte tenu de l'intérêt général pour les métadonnées et dans l'hypothèse où des modèles économiques en faisant usage seront inventés, on peut s'attendre à une implémentation massive de logiciels compatibles RDF, qui pourrait en particulier donner une seconde naissance à l'étiquetage du contenu.

Situation en France

Une situation contrastée (culture de la centralisation)

Connexion et hébergement

En ce qui concerne les structures d'accès à l'Internet, la France est encore dans une phase de construction rapide du marché et de structuration de l'offre. Il y a une tendance à la concentration des acteurs ayant une implantation sur l'ensemble du territoire (Wanadoo/MSN, AOL/Compuserve, Infonie, Club Internet, ...). Actuellement, la concurrence joue plus sur les prix, la facilité d'utilisation et les services proposés (email, hébergement, contenu) que sur la qualité de service, même si la communauté des utilisateurs pionniers reste très sensible sur ce point et si des essais comparatifs intégrant des mesures de performance sont publiés par les organisations de consommateurs et les revues spécialisées. On peut cependant remarquer, étant donné la très forte croissance dans le domaine (les capacités et le nombre d'utilisateurs font plus que doubler tous les ans, les fournisseurs d'accès installent continuellement de nouveaux équipements), que toute mesure n'a qu'une durée de vie limitée à quelques mois, voire quelques semaines. Il suffit qu'un fournisseur d'accès change un équipement de son réseau pour que la situation s'améliore nettement !

Evolution du nombre cumulé d'abonnements souscrits auprès de

fournisseurs d'accès membres de l'AFA - Source : AFA

Evolution du nombre cumulé d'heures de connexion des fournisseurs d'accès

membres de l'AFA - Source : AFA

Une entreprise peut héberger son site sur les serveurs d'un prestataire situé n'importe où dans le monde (tout en ayant la possibilité d'avoir un nom de domaine en ".fr"). Toutefois, la situation géographique peut influer sur les performances (en fonction de la localisation de l'audience, des capacités de connexion à l'Internet, de la proximité d'un site d'interconnexion ou d'une artère).

Adressage et nommage

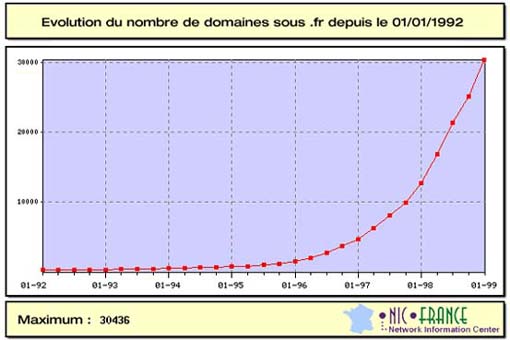

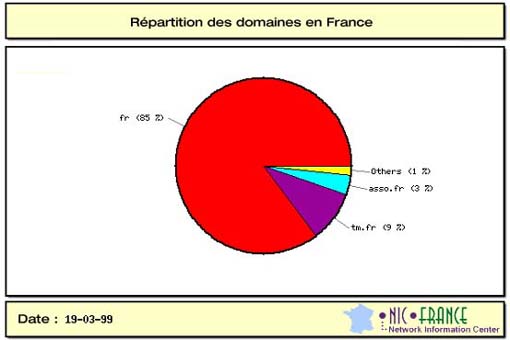

Les noms de domaines pour la France (".fr") sont gérés par l'association AFNIC qui a établi des règles de fonctionnement (la Charte de nommage du domaine ".fr") destinées à clarifier l'attribution des noms et à structurer les sous-domaines (".tm.fr" pour les marques, ".asso.fr" pour les associations...). En conditionnant l'attribution des noms de domaines à la fourniture de documents officiels (extraits Kbis ou JO, certificat INPI), l'AFNIC contribue à augmenter la confiance générale dans l'Internet. Cependant, il semble que les restrictions imposées et la lourdeur administrative poussent certains utilisateurs à préférer un domaine ".com" plutôt que ".fr" (30400 domaines français sous ".fr" le 1/1/1999 contre 37400 sous ".com" le 10/2/1999 - source AFNIC). Dans un contexte de mondialisation de l'économie, la démarche la plus sage pour les entreprises ou organismes à vocation internationale est sans doute l'enregistrement dans plusieurs domaines. Il faut noter que la France participe activement aux travaux sur l'évolution de l'attribution des noms de domaines. France Télécom/Oléane fait partie des 5 entreprises et organismes sélectionnés par l'ICANN pour tester la mise en concurrence de l'attribution des noms des sous-domaines de ".com", ".org" et ".net".

Annuaires

La France dispose de quelques moteurs de recherche de bon niveau (Voilà, Nomade, Ecila). Cependant, les moteurs de recherche indexent en général l'information à partir de mots-clés, et sont souvent indépendants de la langue. Les entreprises internationales sont facilement capables de mettre en ligne une version française de leurs services (Yahoo!, Excite, Lycos, par exemple, qui utilisent le domaine ".fr" mais sont hébergés hors de France !). Il faut cependant remarquer que quelques rubriques des annuaires doivent être spécifiques aux pays traités notamment celles concernant les institutions, les administrations, les collectivités locales, ...

Pionnière dans la mise en ligne des annuaires téléphoniques, la France dispose aujourd'hui d'annuaires téléphoniques performants et accessibles gratuitement sur Internet (par exemple le service des Pages Blanches). En ce qui concerne les autres annuaires personnels, comme ceux contenant les adresses de boîtes à lettres électroniques, une déclaration à la CNIL est théoriquement obligatoire mais en pratique difficile à imposer dans un contexte international.

Sécurité

Il n'existe pas encore en France de structure officielle de coordination et d'alerte contribuant à la préservation de l'intégrité des réseaux Internet nationaux. Seul fonctionne le CERT-Renater qui participe au FIRST. Des initiatives industrielles ou gouvernementales sont toutefois en cours. Au niveau européen, il existe un EuroCERT hébergé en Grande-Bretagne mais il ne rassemble pas l'ensemble des pays et offre un service limité.

La réglementation française en matière de cryptologie a été modifiée en 1999. Les euils de chiffrement demandant autorisation ou déclaration ont été relevés à 128 bits. Cette modification permet l'usage et le deploiement de techniques et logiciels standards. Il est également prévu de modifier la législation pour libéraliser totalement l'usage de la cryptologie.

Depuis les décrets de 1998 simplifiant l'utilisation des techniques cryptographiques, notamment pour l'authentification et la signature (facteur sans doute plus déterminant pour engendrer la confiance que le chiffrement), une offre française d'autorités de certification se met progressivement en place (sociétés Certplus ou Certiposte par exemple). Toutefois le déploiement est encore limité.

Protection de la vie privée et des données personnelles

La France est depuis longtemps particulièrement active dans le domaine de la protection de la vie privée avec la loi du 6 janvier 1978 et l'établissement de la CNIL (Commission Nationale de l'Informatique et des Libertés). La CNIL s'est tenue informée très tôt des pratiques en vigueur sur Internet, et a joué un rôle moteur dans l'établissement de la directive européenne du 24 octobre 1995. Guy Braibant a été chargé par le Premier ministre d'un rapport remis le 3 mars 1998, visant à éclairer le législateur sur la transposition de cette directive au droit français.

Du fait du travail législatif déjà accompli par la France dans le domaine, et de sa large diffusion dans différents aspects du droit commercial, du droit social, etc., la transposition française de la directive européenne est un travail lourd, ce qui explique que début 1999 la transposition ne soit pas encore achevée. Le Premier Ministre, Lionel Jospin, a annoncé dans un communiqué de presse du 3 mars 1998, suite à la remise du rapport Braibant, que le projet de loi serait soumis à la consultation de la Commission Nationale Consultative des Droits de l'Homme et à celle de la CNIL avant d'être présenté au Parlement. Dans une conférence de presse du 19 janvier 1999 à l'issue du Comité interministériel pour la société de l'information, il a indiqué que les orientations que le Gouvernement proposera viseront à maintenir le niveau élevé de protection des données personnelles actuellement garanti aux citoyens français, et que ceci devrait conduire au renforcement des moyens de la CNIL et de son pouvoir de contrôle.

Il est clair qu'en matière de politique de protection de la vie privée et des données personnelles, la France dispose d'un capital d'expérience et de compétences au tout premier niveau mondial. L'enjeu est donc maintenant de mettre ce capital en application dans l'usage d'Internet, et en particulier de faire le lien avec les technologies qui se profilent dans le domaine.

Etiquetage du contenu

En France, il n'existe aucun système d'étiquetage du contenu. En Europe, le pays pionnier est l'Italie avec le système d'étiquetage à usage de contrôle parental IT-RA. Notons que PICS est encore mal connu en France, malgré des actions de communication du W3C comme par exemple l'atelier PICS organisé en janvier 1998 à Autrans. En particulier, le rapport "Libertés individuelles et libertés publiques sur Internet" remis par l'association IRIS au Conseil d'Etat en octobre 1997 émet un avis assez négatif sur l'étiquetage du contenu et sur PICS dans son annexe VI. Cette vision négative est principalement due à l'utilisation de l'étiquetage dans un but de blocage de l'information indésirable comme dans le contrôle parental, ou à des fins de censure dans des régimes "non démocratiques", et non dans un but positif de déclaration et de sélection de l'information recherchée.

Recommandations

Construire la confiance en s'appuyant sur la décentralisation des responsabilités

Connexion et hébergement

- Encourager l'élaboration et la diffusion d'indicateurs de qualité pour les services de connexion et d'hébergement sur Internet

Le dynamisme et la croissance rapide du monde Internet font qu'il est difficile d'avoir en permanence une vision cohérente de la situation technique et de l'offre. Il convient donc d'encourager toute initiative conduisant à la mise en place d'observatoires objectifs sur la situation dans ce domaine. Ces structures peuvent être soit privées, comme il en existe aux Etats-Unis, soit intégrées au secteur public (hébergement par une université, un organisme officiel ou une administration). Il s'agit d'accompagner et de mesurer la transformation d'Internet en un réseau robuste et fiable fournissant une qualité de service nécessaire pour accéder au statut d'infrastructure essentielle de la vie économique.

La concurrence forte sur l'accès aux réseaux et services de l'Internet doit conduire naturellement à une normalisation des pratiques dans le domaine, aussi bien sur la nature même de l'offre que sur la qualité des prestations fournies. Toutefois, pour améliorer la protection des consommateurs (individus ou entreprises) face à ce domaine technique complexe, il faut favoriser la création et l'utilisation de chartes intégrant des clauses de qualité de service. Ces chartes permettraient de mieux définir les prestations attendues d'un fournisseur d'accès (en complétant par exemple l'initiative de l'AFA, Association des Fournisseurs d'Accès et de Services Internet).

En matière d'hébergement, le développement du marché national passe sans doute par une clarification des devoirs et responsabilités respectifs des fournisseurs d'accès, des hébergeurs et des éditeurs/créateurs de sites.

Adressage et nommage

- Créer une autorité de certification des sites afin de garantir l'identification des sources d'information et de services

La démarche entreprise par l'AFNIC pourrait être complétée par la mise en place conjointe d'une autorité de certification des sites (voir les aspects "Sécurité" de ce chapitre) afin d'augmenter notablement le niveau de fiabilité de l'identification des sources d'information et de services sur Internet.

Sécurité

- Mettre en place des autorités de certification gérées par des administrations et des organismes publics

- Mettre en place une structure d'échange et de coordination chargée de l'information sur les risques et alertes

La libéralisation de la cryptologie en mars 1999 lève un obstacle à l'utilisation en France de moyens de chiffrement à grande échelle. Elle devra sans doute être accompagnée rapidement d'un ensemble de lois claires et cohérentes concernant notamment les obligations vis à vis des autorités d'instruction judiciaire ou des services de sécurité nationale (nécessité d'auto-séquestre des clés par exemple, s'il y a une obligation de preuve de la correspondance entre un message et sa version chiffrée). En matière de fourniture de produits intégrant des mécanismes cryptologiques, la carte à puce constitue souvent une solution élégante et ergonomique. La France pourrait adopter une attitude conquérante dans ce secteur en capitalisant sur l'expérience acquise par les acteurs du domaine.

La libéralisation récente ne modifie toutefois pas la situation en matière d'utilisation de la cryptologie à clé publique pour permettre une confiance accrue lors de consultations ou de transactions sur l'Internet. La mise en place rapide d'autorités de certification sérieuses et efficaces conditionne en partie le déploiement du commerce électronique, de téléprocédures ou de services sectoriels (santé, notaires, justices...). Pour rendre acceptable par l'utilisateur ces mécanismes et pour engendrer la confiance, un soin particulier doit être apporté à l'ergonomie et à la transparence des mécanismes. La mise en place d'autorités de certification gérées par des administrations et des organismes publics semble être aussi de nature à lever certaines réticences à l'utilisation de l'Internet pour la vie administrative.

Pour garantir un niveau de protection correct des réseaux et services Internet français, il conviendrait de mettre en place une structure d'échange et de coordination permettant à tous les acteurs du domaines de se tenir informés des risques et alertes concernant la sécurité et de synchroniser en cas d'incident. Elle pourrait aussi participer à la défense des infrastructures réseaux et services en cas d'attaque organisée. Elle pourrait se synchroniser avec les organismes de sécurité concernés. La France pourrait aussi proposer la mise en place d'une structure équivalente pour protéger les intérêts de l'ensemble des pays européens.

Protection de la vie privée et des données personnelles

- Lancer dans l'administration française des plateformes expérimentales conformes aux modalités de la directive européenne et de la future loi

L'enjeu est de tirer parti du capital d'expériences et de compétences acquis au niveau français dans le domaine pour mettre au plus tôt en application les principes exposés par la directive européenne 95/46/CE et dans sa transposition en cours dans le droit français. Les recommandations sont donc :

- de lancer dans chaque administration française, parallèlement à la mise en place de cette transposition et en liaison avec la CNIL, des expérimentations préparant les modalités d'implémentation de la directive et de la future loi, en étudiant en particulier la proposition technologique P3P ;

- d'être proactif dans l'implémentation des principes nécessaires au respect de ces législations au sein des logiciels disponibles en "Open Source" comme Netscape Communicator (Mozilla) et Apache server.

Etiquetage du contenu

- Encourager le développement de systèmes d'étiquetage "positif" dans un but pédagogique

- Encourager l'étiquetage déclaratif du contenu auprès des fournisseurs d'information

La recommandation est d'utiliser les technologies de métadonnées pour un étiquetage "positif" de l'information, à des fins de déclaration et de sélection, et non pas de blocage.

Ce principe s'applique bien aux usages dans lesquels il existe une communauté d'utilisateurs (potentiellement grande) partageant les mêmes centres d'intérêts, en particulier les usages où la rentabilité du modèle économique n'est pas le premier moteur. On pense en premier lieu à l'éducation : des systèmes d'étiquetage pourraient être définis et utilisés par les communautés scolaires et enseignantes dans un but pédagogique et constructif.

L'étiquetage déclaratif du contenu pourrait également être un outil utile dans les situations où il s'agit de définir les responsabilités respectives entre un éditeur d'information et l'hébergeur effectif de cette information.